芯片资讯

- 发布日期:2024-01-05 14:18 点击次数:84

在AI算力、算法和数据人工智能行业三要素中,AI算力更是重中之重,业界厂商通过对各类AI硬件不断迭代为算力狂飙的需求提供强有力保障。自ChatGPTAI、GPT-4模型发布火爆出圈后,在引发了普罗大众对AI大模型热情的同时,也引燃了AI算力的战火。全球科技巨头纷纷发布AI大模型、AI训练卡产品都是入场者争夺AI制高点的战争缩影。

1、AI异构计算三分天下,GPU表现异常亮眼

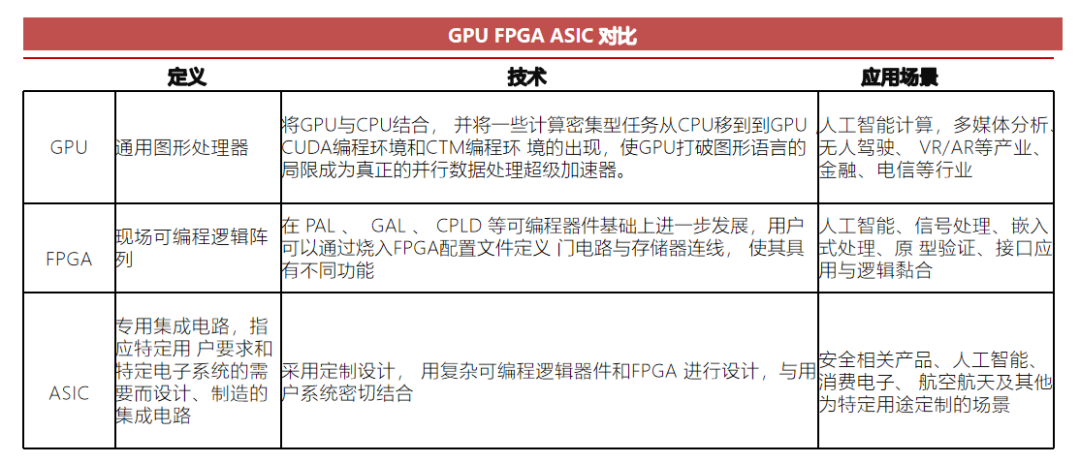

众所周知,人工智能(尤其是大模型新兴应用领域)对AI算力需求超过了通用CPU的摩尔定律的发展速度,而异构计算的性能增长恰恰能够满足这些新兴领域的算力需求发展方向和趋势。异构计算领域,目前呈现出GPU、FPGA、ASIC芯片三分天下的局面,GPU、FPGA、ASIC芯片都会有自己独特的技术特长和应用领域,有自己独特的客户群体。

ASIC芯片可以获得最优性能,即面积利用率高、速度快、功耗低;但AISC开发风险极大,算法是固定,而且从研发到市场的时间周期很长,不适合例如深度学习快速迭代的领域。大多是具备AI算法又擅长芯片研发的巨头参与,如 Google 的TPU。 FPGA称为现场可编程门阵列,用户可以根据自身的需求进行重复编程,相比之下,具有可硬件编程的特点,灵活性好;但基本单元的计算能力有限,速度和功耗存在不足。FPGA 在工业互联网领域、工业机器人设备领域应用前景十分巨大。 GPU具备高效的并行性、高密集的运算、超长流水线,以及成熟生态,最先被引入深度学习;GPU针对不同应用领域的需求,增加了专用向量、张量、矩阵运算指令,提升浮点运算精度和性能,以满足天气预报、工业设计、基因工程、药物发现、金融工程、自动驾驶等不同计算场景的需求。 综合考虑性能、能效比和编程灵活性等因素,GPU明显优于ASIC、FPGA等芯片,并成为目前AI加速服务器的最主流选择。 目前,英伟达和AMD是目前全球GPU的领军企业,两家合计获取了全球GPU绝大部分市场份额。国内海光信息、寒武纪等公司的GPU产品已经实现规模化销售。 全球来看,英伟达的H100及A100、AMD的MI100及MI200等均为主流的GPGPU产品型号。据IDC数据显示,2021年GPU服务器份额占国内AI加速服务器市场的88.4%,2021-2025年间年复合增速为19.1%。据Jon Peddie Research数据显示2022Q1英伟达占据79%市场份额,AMD占据21%。英伟达在独立GPU领域一枝独秀。

在中国市场上,根据IDC数据,2021年英伟达占国内AI加速卡80%以上市场份额,2015-2021年间年复合增速高达77.4%,处于市场领先地位。

2、英伟达中国版GPU限制及可供应性风险

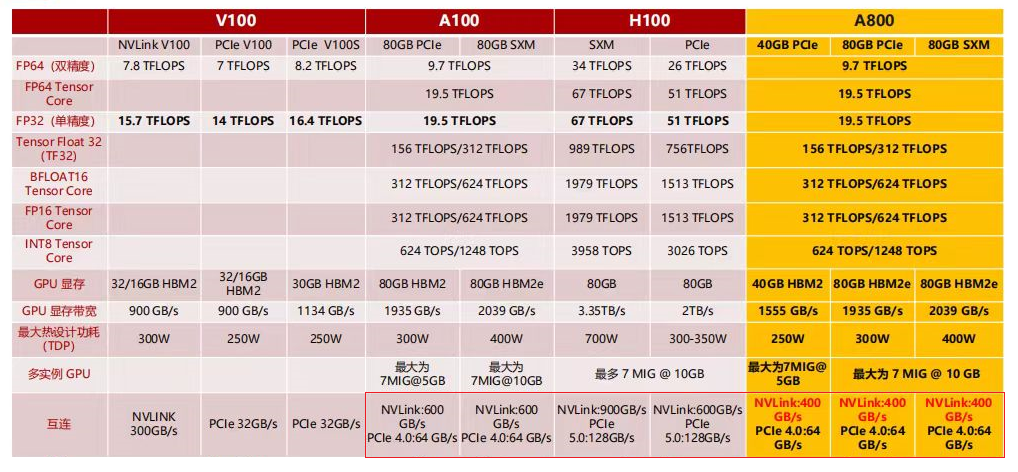

无论在HPC高性能计算,科学研发领域,还是人工智能大模型场景,尤其是对算力要求的比较高Training(训练)环节,AMD的MI 100、MI 200以及Nvidia的A100,H100都是GPU领域的超强算力芯片,极其普遍的应用在AI服务器中实现加速计算,提供计算精度,减少训练周期。 NVIDIA A100、H100等加速计算卡的需求过于火爆,即便在台积电增加了大量的订单,紧急提升产能,依然无法满足。但在中国市场上,由于美国的禁令,NVIDIA基于中市场策略定制了特供版A800、H800。那么,中国特供版A800和H800与A100和H100的具体差距?主要差距是互联后整体集群带宽的下降。A800的互联带宽从A100的600GB/s下降到400GB/s,H800的互联带宽从H100的900GB/s下降到450GB/s。本身单卡的算力不变,但是集群卡间互联的带宽限制整个集群的算力规模,从而限制了集群性能,相当于限制了AI模型训练精度以及中国AI技术发展。

即便如此,NVIDIA特供版A800、H800发布也是异常抢手,在国内大型互联网企业在采购潮的推动下,涨价幅度已经超过40%。在如此大模型高算力市场需求下,依靠国外GPU技术发展AI技术本身就是伪命题,如同沙滩筑高楼;同时,在可供应性和技术演进上成了极大风险。

3、国内GPU厂商概述及国产化应对策略

美国对中国GPU等芯片的“卡脖子”制裁也给国内产品替代英伟达带来非常大的机会。国产AI芯片厂商持续发力,对标行业龙头已缩小差距。在AI加速和高性能计算领域,国内主要有GPGPU和NPU两条技术路径;GPGPU技术沉淀深、生态兼容广,NPU发展迅速,但算力供给单一性和生态壁垒比较难打破,两条路径都得到相应厂商的支持和发展,在特定领域性能都达到业界一流水平。

相较而言,GPGPU路线更加符合AI算力发展需求,更具潜力。GPGPU也叫做通用GPU,优势在于具备大规模并行计算的能力,可快速开发高能效的应用程序,在产品性能、通用性、易用性等方面优势明显,全球9成以上商用AI系统的选择GPGPU架构芯片,在训练负载方面更是如此。而且,当前AI应用基本全都建立在GPGPU架构的软件开发平台上,生态体系更加完善,好用,易用。AI技术发展日新月异,AI软件开发者通过在GPGPU平台开发,能够更好的提高生产力。

ASIC架构,优势在于根据产品的需求, 亿配芯城 进行特定设计和制造的集成电路,因此计算速度快,能耗更低。它的出现存在一个理论前提,即算法发展相对成熟,已发现最优算法,通过将软件固化到硬件执行,以实现最优效率。由于当前AI算法、模型快速迭代发展,ASIC架构需要投入大量的资金,以及经历较长的研发和工程周期,容易出现量产即落后的局面。另外,国际上还有基于FPGA架构开发AI芯片,虽然可根据自身需求进行重复编程,但缺点在于频率较低,单元计算能力有限,价格昂贵。而且,基于FPGA的AI应用开发,需要软件工程师同时具备软件、硬件能力,开发难度较大;并且目前FPGA被国外巨头垄断,因此很少有FPGA架构的国产AI芯片。

相对于ASIC与FPGA而言,国内对GPGPU芯片其实需求更为迫切。大模型预训练面临着计算资源需求、数据集规模、训练时间和效率、参数调优和模型调整、以及泛化能力和适应性等多个难题。应对这些难题需要综合考虑硬件资源、数据管理、算法设计等多方面因素。因此,算力领先、软件完善的 GPGPU成为先进大模型的首选算力来源。而且,随着AI应用向多模态进一步发展,通用性更优的GPGPU可以更好的支持这类应用发展

另外,国内对GPGPU芯片的需求不止于芯片可提供多少算力,是否能满足应用场景所需的计算精度也同样重要。原因在于,AI应用视场景不同,需要算力精度不同。例如AICG领域对图像和语音的处理,用32位、16位计算精度即可;而部分科学计算,则需要用到FP64双精度浮点运算,才可保证模型训练和预测结果的准确性。总而言之,AI算力的全面发展,需要全精度、通用性强的GPGPU芯片支撑。

当前,国内AI芯片厂商数量约在6000+家,其中主流厂商数量约60余家,主要分为三个梯队,第一梯队包括海光、华为、寒武纪等。划分原因在于,第一梯队厂商有成熟产品,且已有商业化量产规模的应用。

海光:DCU产品深算系列,兼容通用的“类 CUDA”环境以及国际主流商业计算软件和人工智能软件,对标主流 NVIDIA A100 产品,海光 DCU 单芯片产品基本能达到与其相近的性能水平。并且,海光DCU深算一号,国内唯一能支持全部算力精度,可以满足需要更高精度的数学计算的需要。GPGPU架构,让其通用性更强,海光DCU产品在AI计算、大数据处理、商业计算等领域发挥着重要作用。

华为昇腾:产品包括昇腾310、910,自研达芬奇架构实现较低功耗和较好散热,可在华为庞大的AI软件工程师支持下,通过运行华为的全栈软硬件平台,并且深度适配、迁移和优化,可以应用于云边端全场景覆盖,目前已形成较为完善的生态。

寒武纪:产品主要由云端芯片与边缘芯片等组成,产品体系丰富,适配AI应用及各类算法,产品的能效较好,并掌握了智能芯片架构、编译器、工具链等核心技术。但因为AISC架构芯片的天然劣势,使得寒武纪产品在实际应用中需要大量资金、人才投入,落地部署困难重重,实际应用限制多多。

第二梯队包括,燧原、昆仑芯、天数、壁仞、沐曦等近几年成立的初创企业。这几家厂商虽然发布了产品,但由于AI芯片产品化、复杂度等原因,在实际应用中进展有限,或开始在某些领域局部试水,或者还在努力建设软件生态,集群部署方案等。

第三梯队包括龙芯、景嘉微等,这两家厂商有意向进军AI计算领域,但尚无AI芯片量产。龙芯作为国产CPU领域的主流厂商,5月份宣布集成龙芯自研GPGPU的第一款AI计算芯片,预计将于 2024 年一季度流片。而景嘉微作为国内最早投入GPU研发的厂商之一,近期也宣布募资42亿元投入高性能GPGPU芯片研发及产业化项目。这两家厂商作为国内计算芯片代表厂商,如今在布局AI计算芯片研发,终于迈出了第一步。

4、总结

AI大模型催生GPU市场需求剧增,在严峻的国际形势下,GPU的国产替代进程刻不容缓,海光信息深算一号已基本具备英伟达高端 GPU的技术能力,在紧张的局势背景下,未来有望推动高端GPU国产替代进程。

在特定AI应用领域(尤其是GPU图形计算和AI推理领域),国内GPU厂商从技术到生态都具备一定积累,随着产品不断迭代更新,以及在AI训练领域持续发力,未来在争夺AI制高点的战争中发光发热,从而缓解“卡脖子”问题和供应风险。

- 亿配芯城接入DEEPSEEK AI 大模型,让芯片采购更灵活2025-04-25

- AMD在AI芯片市场的崛起:挑战英伟达的领先地位2024-01-19